- Instalar deepseek 32b en nuestra máquina ha sido trivial.

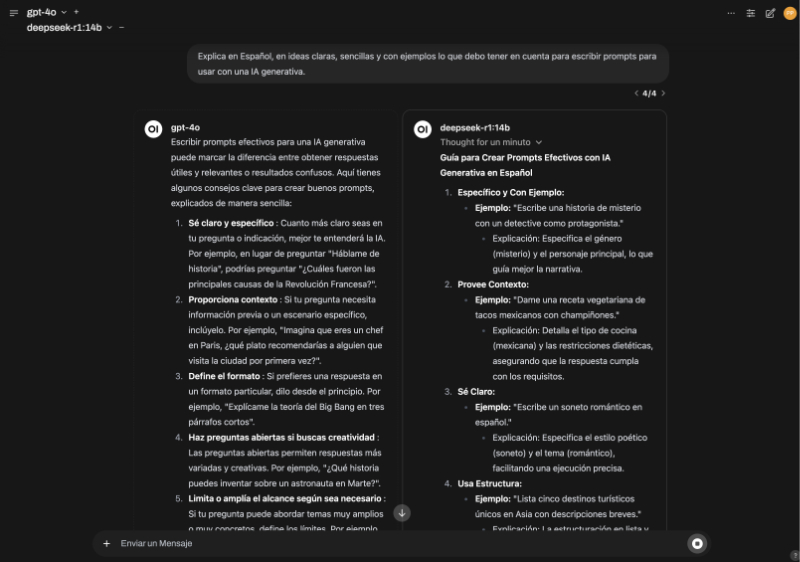

Tenemos una maquina potente: un macbook pro con un m2 ultra y conn 96gb de memoria (2tb en hd) No es una máquina habitual ya que es un top gama de apple. Pero es un portátil! Su consumo en watios no es excesivo. (poco más de 300 w a pleno rendimiento y 45 en reposo). Tiene instalado Ollama y OpenWebui para simplificar pruebas y comparar modelos (arena). Instalar DeepSeek 32b fue tan simple como dar con el repositorio y decirle a OpenWebui que lo añada a Ollama. Punto. - Las pruebas no han consistido en que cuente las R de una palabra o que nos calcule el nº de hermanos de las hermanas de Ana. Son pruebas reales, en condiciones de trabajo real, tratando de responder una pregunta: ¿me cambio a mi Deepseek local o continúo con ChatGPT 4o? Hay que tener en cuenta que no podemos tener el modelo de ChatGPT en local y que la comparación es entre un modelo directo y uno de razonamiento ( no está ni en la misma dimensión ni en el mismo nivel. Pero la pregunta sigue siendo válida: podemos sustituir un modelo externo como GhatGPT por un modelo local o tenemos que esperar un poco más?

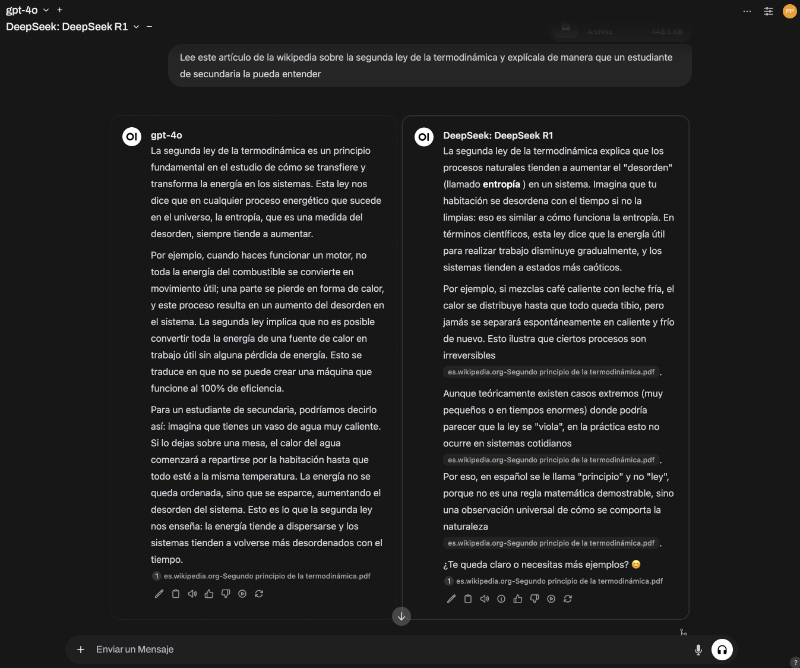

- Las primeras impresiones: comparativamente, ChatGPT 40 resulta abrumadoramente rápido. En nuestro ordenador, deepseek crea el texto a mayor velocidad de lo que lo podemos leer pero su desarrollo es completamente percibible y esperar a que termine de “pensar” y nos de una respuesta a veces se hace pesado. Sin embargo, ver el proceso de razonamiento resulta fascinante… ya es de por sí un añadido y a veces es más revelador que la propia respuesta. Posiblemente si se usa un modelo de razonamiento, hay que cambiar la metodología de trabajo para usarlo como ayudante.

- La calidad de las respuestas es comparable. Usarlo con documentación para que la analice y extraiga conclusiones, elabore resúmenes o compare es perfectamente posible y puede sustituir a GPT 4o sin problemas.

- Gracias al wrapper usado -ollama+openwebui- es posible imitar algunas de las funcionalidades de ChatGPT, como es la de crear asistentes. Es una tarea más pesada, y para poder usar el asistente -que los use un tercero- es más farragoso que con chatGPT, pero es perfectamente posible y no es cosa de deepseek sino del wrapper. el modelo cumple perfectamente.

- Como ayudante a la programación: usándolo como modelo base en Roo Cline (add on para Visual Studio Code,) es casi tan bueno como Claude Sonnet 3.5 -el referente actual- . Si acaso es un a alternativa plausible, algo más lenta que usar el modelo remoto, pero válida. Nuestra re3comendación es que se vayan alternando los modelos ya que pueden dar enfoques diferentes al mismo prompt y será decisión del programador aceptar un enfoque u otro.

- Usarlo desde un router de LLM como OpenRouter puede ser una excelente idea. OpenRouter permite alternar modelos con un click y probar si el modelo de 70b es mejor que el de 32 o cualquiera de sus destilados es muy sencillo. Resulta llamativo que el principal -con mucha diferencia- consumidor de tokens que se hacen vía openrouter sea Cline….(otro fork de visual studio code) con 18 BILLONES de tokens servidos en un solo día y seguidos de RRO Cline con 9 BILLONES…..

by Grupo 1MilionBot LAB, Pedro Pernias.